В современном цифровом мире каждую секунду генерируются гигантские объемы информации. От наших постов в социальных сетях и онлайн-покупок до данных научных экспериментов и датчиков Интернета вещей — мы живем в эпоху больших данных, или Big Data. Но что именно означает этот термин и почему он стал так важен? Значение больших данных трудно переоценить, ведь они открывают новые горизонты как для коммерческих компаний, так и для научных учреждений; об этом и многом другом поговорим далее на imariupolchanyn.com/ru.

Big Data — это не просто «много данных». Этот термин описывает наборы данных, настолько огромные по объему, разнообразные по формату и быстрые по поступлению, что их невозможно эффективно собирать, хранить, обрабатывать и анализировать с помощью традиционных инструментов управления данными и реляционных баз данных. Ключевая идея заключается не только в масштабе, но и в потенциале этих данных: их глубокий анализ позволяет выявлять скрытые закономерности, неочевидные корреляции, рыночные тенденции, предпочтения клиентов и другую полезную информацию. Именно эта способность превращать сырые данные в ценные знания (инсайты) делает Big Data мощным инструментом для принятия обоснованных бизнес-решений, ускорения научных открытий, улучшения государственных услуг и решения глобальных проблем. В этой статье мы подробно разберемся в концепции больших данных, ее фундаментальных характеристиках, технологиях обработки и, самое главное, рассмотрим конкретные примеры того, как анализ Big Data трансформирует современный бизнес и науку.

Ключевые характеристики Big Data: Классическая Модель «3V» и ее расширение до «5V» (и более)

Чтобы лучше понять феномен больших данных, эксперты первоначально определили три основные характеристики, известные как модель «3V»: Объем (Volume), Скорость (Velocity) и Разнообразие (Variety). Со временем, по мере развития технологий и более глубокого понимания проблемы, эту модель расширили, добавив еще как минимум две важные характеристики: Достоверность (Veracity) и Ценность (Value). Рассмотрим каждую из них подробнее.

1. Объем (Volume)

Это самая интуитивно понятная характеристика. Big Data означает чрезвычайно большие объемы данных. Речь идет не о гигабайтах, а о терабайтах (ТБ), петабайтах (ПБ), эксабайтах (ЭБ) и даже зеттабайтах (ЗБ) информации. Для сравнения, один петабайт — это примерно 20 миллионов четырехдверных шкафов, заполненных текстом, или видео высокой четкости продолжительностью 13,3 года. Источники этих данных колоссальны: социальные сети (только Facebook ежедневно генерирует петабайты данных в виде постов, фото, видео, лайков), транзакции электронной коммерции, данные с миллиардов устройств Интернета вещей (IoT), потоковое видео и аудио, спутниковые снимки, логи веб-серверов, данные научных симуляций и экспериментов (например, Большой адронный коллайдер). Традиционные системы хранения и обработки данных просто физически не способны справиться с такими масштабами.

2. Скорость (Velocity)

Эта характеристика описывает высокую скорость генерации и поступления данных, а также потребность в их быстрой обработке, часто в режиме реального времени или близком к нему. Данные не просто накапливаются; они льются непрерывным потоком. Примеры включают биржевые котировки, обновляющиеся за миллисекунды, постоянные потоки данных из социальных сетей, непрерывные показатели с промышленных датчиков или медицинских мониторов, данные геолокации с мобильных устройств. Необходимость анализировать эти данные «на лету» (stream processing) является ключевой для многих приложений, таких как выявление мошеннических транзакций в момент их совершения, мониторинг состояния пациентов, управление дорожным движением или быстрое реагирование на изменения рыночных условий. Медленная обработка может сделать полученную информацию устаревшей и бесполезной.

3. Разнообразие (Variety)

Большие данные поступают в чрезвычайно разнообразных форматах, что значительно усложняет их хранение и анализ в традиционных структурированных базах данных. Выделяют три основных типа:

- Структурированные данные: Это данные, имеющие четко определенную модель и формат, легко организуемые в таблицы со строками и столбцами. Примеры: данные в реляционных базах данных (SQL), таблицы Excel, записи о клиентах в CRM-системах, финансовые транзакции. Это наиболее привычный тип данных, но он составляет лишь небольшую долю Big Data (около 20%).

- Полуструктурированные данные: Эти данные не соответствуют жесткой структуре реляционных баз данных, но содержат определенные теги, маркеры или другие организационные элементы, облегчающие их анализ. Примеры: файлы XML, JSON, данные веб-страниц (HTML), электронные письма, данные из некоторых NoSQL баз данных.

- Неструктурированные данные: Это данные, не имеющие заранее определенной структуры или модели. Они составляют подавляющее большинство (около 80%) всех данных, генерируемых сегодня. Примеры: текстовые документы, сообщения в мессенджерах и социальных сетях, электронные письма, изображения, аудиофайлы, видеозаписи, данные с сенсоров, презентации PowerPoint. Анализ таких данных требует сложных методов, включая обработку естественного языка (NLP), компьютерное зрение и распознавание речи.

Эффективная работа с Big Data требует способности интегрировать и анализировать данные всех трех типов.

4. Достоверность (Veracity)

Эта характеристика касается степени доверия к данным, их точности, качества и надежности. Большие данные, собранные из множества источников, часто бывают «грязными» – неполными, противоречивыми, неточными, содержать ошибки ввода, дубликаты, шумы (например, от сенсоров) или быть предвзятыми (biased). Данные из социальных сетей могут быть субъективными, эмоционально окрашенными или даже целенаправленно ложными (фейки, дезинформация). Неопределенность и недостоверность данных могут существенно повлиять на результаты анализа и привести к принятию ошибочных решений. Поэтому обеспечение достоверности данных через процессы очистки (data cleaning), валидации, устранения противоречий и оценки надежности источников является критически важным и часто очень трудоемким этапом работы с Big Data.

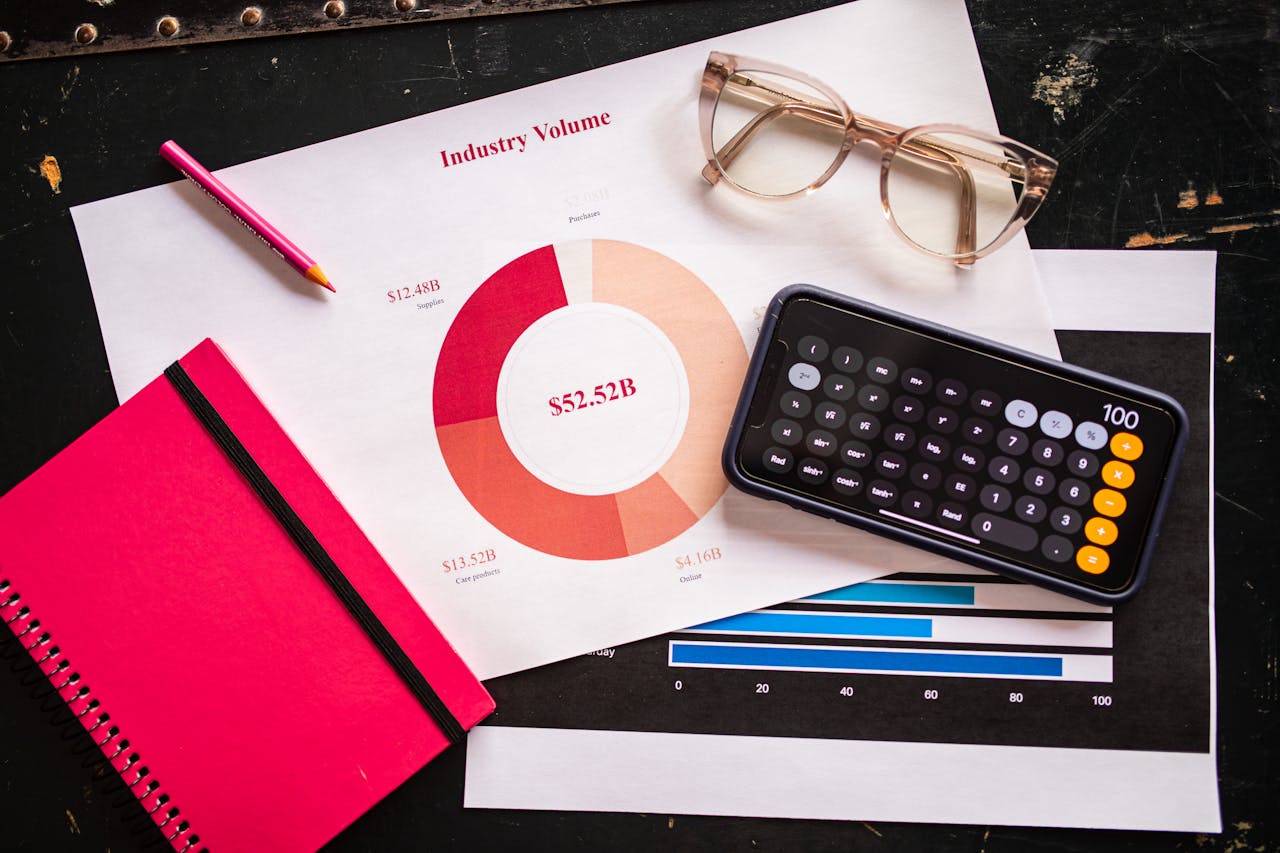

5. Ценность (Value)

Пожалуй, самая важная характеристика, являющаяся конечной целью всей работы с большими данными. Сами по себе терабайты информации не имеют никакой ценности, если их невозможно превратить в полезные знания, инсайты и конкретные действия, приносящие пользу. Ценность может измеряться по-разному: увеличением прибыли, снижением затрат, улучшением клиентского сервиса, оптимизацией процессов, созданием новых продуктов, повышением эффективности научных исследований, улучшением общественного здоровья и т.д. Определение потенциальной ценности данных и разработка стратегии ее извлечения и использования является ключевой задачей для любой организации, инвестирующей в технологии Big Data. Без четкого понимания того, какую ценность нужно получить, анализ больших данных рискует превратиться в дорогостоящий процесс ради процесса.

Иногда к этим пяти «V» добавляют и другие, такие как Вариативность (Variability) – изменчивость потоков данных, и Визуализация (Visualization) – необходимость представлять результаты в понятном виде.

Основные Источники Big Data

Понимание источников больших данных помогает осознать их вездесущность и потенциал. Основными «генераторами» Big Data являются:

- Интернет и Социальные сети: Это один из самых богатых источников. Сюда входят данные с веб-сайтов (логи посещений, клики, пути навигации), поисковых систем (запросы пользователей), блоги, форумы, обзоры товаров, и, конечно, социальные платформы (Facebook, Instagram, Twitter, LinkedIn, TikTok и др.). Генерируются огромные объемы текстовых данных, изображений, видео, лайков, репостов, комментариев, данных о связях между пользователями и их интересах.

- Машинные данные (Machine-Generated Data) / Интернет вещей (IoT): Миллиарды устройств, подключенных к сети, непрерывно генерируют данные. Это могут быть промышленные датчики (температура, давление, вибрация на оборудовании), сенсоры на транспорте (GPS, скорость, расход топлива), счетчики коммунальных услуг («умные» счетчики электроэнергии, воды, газа), носимые устройства (фитнес-трекеры, смарт-часы, медицинские мониторы), камеры видеонаблюдения, «умные» домашние устройства (термостаты, освещение) и многое другое. Эти данные часто поступают в реальном времени.

- Транзакционные данные: Данные, генерируемые в результате операционной деятельности компаний. Сюда относятся записи о продажах, покупках, банковских транзакциях, данные платежных систем, записи о доставке товаров, данные из систем управления взаимоотношениями с клиентами (CRM), систем планирования ресурсов предприятия (ERP), данные колл-центров (записи звонков, логи чатов).

- Мультимедийные данные: Огромные объемы неструктурированных данных в виде фотографий (Flickr, Instagram), видео (YouTube, Netflix, TikTok, камеры наблюдения), аудиозаписей (подкасты, музыкальные стриминговые сервисы, записи разговоров). Их анализ (например, распознавание образов или речи) представляет собой отдельный вызов.

- Научные данные: Результаты экспериментов, наблюдений и симуляций в различных областях науки. Например, данные секвенирования генома, астрономические наблюдения (снимки неба, данные радиотелескопов), результаты климатического моделирования, данные физических экспериментов (как на LHC), медицинские исследования (клинические испытания, данные электронных медицинских карт).

- Публичные (открытые) данные: Данные, предоставляемые правительственными учреждениями, международными организациями и некоммерческими структурами. Это могут быть демографические данные (перепись населения), экономическая статистика, метеорологические данные, данные о транспортной инфраструктуре, экологический мониторинг, государственные реестры и т.д.

- Биометрические данные: Данные, связанные с уникальными физическими характеристиками человека, такие как отпечатки пальцев, сканирование сетчатки глаза, распознавание лица, анализ голоса. Используются для идентификации и безопасности.

Технологический Стек и Этапы Анализа Big Data

Анализ больших данных — это многоэтапный процесс, требующий использования специализированных технологий и инструментов, которые часто называют «экосистемой Big Data». Основные этапы и ключевые технологии:

- 1. Сбор данных (Data Acquisition/Ingestion): На этом этапе происходит сбор сырых данных из разнообразных источников. Используются инструменты для передачи данных, такие как Apache Kafka (для потоковой передачи данных в реальном времени), Apache Flume, Sqoop (для передачи данных между Hadoop и реляционными базами данных), а также различные API и ETL-инструменты (Extract, Transform, Load).

- 2. Хранение данных (Data Storage): Из-за характеристик Big Data (объем, разнообразие), традиционные реляционные базы данных часто не подходят. Используются:

- Распределенные файловые системы: Самая известная – HDFS (Hadoop Distributed File System), которая позволяет хранить огромные файлы, разбивая их на блоки и распределяя по кластеру обычных серверов.

- NoSQL базы данных: Нереляционные базы данных, оптимизированные для различных моделей данных и масштабируемости. Основные типы:

- Документные (MongoDB, Couchbase): Хранят данные в виде документов (например, JSON).

- Ключ-значение (Redis, Riak): Простые хранилища пар ключ-значение.

- Колоночные (Cassandra, HBase): Оптимизированы для запросов по колонкам, хорошо подходят для больших наборов данных с небольшим количеством колонок.

- Графовые (Neo4j, Amazon Neptune): Предназначены для хранения и анализа данных со сложными связями (например, социальные сети, рекомендательные системы).

- Озера данных (Data Lakes): Хранилища, позволяющие хранить большие объемы сырых данных в их нативном формате без предварительной структуризации. Это обеспечивает гибкость для дальнейшего анализа.

- Хранилища данных (Data Warehouses): Более структурированные хранилища, содержащие очищенные и интегрированные данные, оптимизированные для бизнес-аналитики и отчетности. Часто используются вместе с озерами данных.

- 3. Обработка данных (Data Processing): Это этап очистки, трансформации, агрегации и подготовки данных для анализа. Из-за больших объемов используются фреймворки для распределенных вычислений:

- Apache Hadoop (с MapReduce): Исторически первый популярный фреймворк для пакетной обработки больших данных. MapReduce – это модель программирования для распределенных вычислений.

- Apache Spark: Более современный и быстрый фреймворк, который может выполнять обработку данных в оперативной памяти (in-memory processing), что значительно ускоряет работу. Поддерживает как пакетную обработку, так и обработку потоковых данных (Spark Streaming), SQL-запросы (Spark SQL) и машинное обучение (MLlib).

- Другие фреймворки: Apache Flink (для потоковой обработки), Apache Storm.

- 4. Анализ данных (Data Analysis): Применение алгоритмов и методов для выявления ценных инсайтов. Это может включать:

- Описательная аналитика (Descriptive Analytics): Что произошло? (Отчеты, дашборды)

- Диагностическая аналитика (Diagnostic Analytics): Почему это произошло? (Поиск причин)

- Предиктивная (прогнозная) аналитика (Predictive Analytics): Что может произойти? (Прогнозирование будущих событий с помощью статистических моделей и машинного обучения)

- Предписывающая аналитика (Prescriptive Analytics): Что нужно сделать? (Рекомендации по оптимальным действиям)

- Статистический анализ, Машинное обучение (ML), Глубокое обучение (DL), Обработка естественного языка (NLP), Анализ тональности (Sentiment Analysis), Анализ временных рядов, Кластеризация, Классификация.

- 5. Визуализация данных и Интерпретация (Data Visualization & Interpretation): Представление результатов анализа в понятной визуальной форме (графики, диаграммы, карты, интерактивные дашборды) для облегчения понимания и принятия решений. Популярные инструменты: Tableau, Microsoft Power BI, Qlik Sense, Looker, D3.js. На этом этапе происходит интерпретация результатов и формулировка выводов.

Применение Big Data в Бизнесе: От Оптимизации до Инноваций

Для современного бизнеса анализ больших данных превратился из опции в стратегическую необходимость. Компании используют инсайты, полученные из Big Data, для достижения конкурентных преимуществ во многих направлениях:

Улучшение Понимания Клиентов и Персонализация

Пожалуй, самое распространенное применение. Анализируя историю покупок, поведение на веб-сайте и в мобильных приложениях, активность в социальных сетях, демографические данные, отзывы и запросы в службу поддержки, компании могут создать 360-градусный портрет клиента. Это позволяет:

- Глубокая сегментация аудитории: Выделение узких групп клиентов со схожими потребностями и поведением для более точного таргетинга.

- Гиперперсонализация: Предоставление индивидуальных предложений, контента и опыта взаимодействия в реальном времени. Классические примеры – системы рекомендаций товаров на Amazon, фильмов на Netflix, музыки на Spotify.

- Прогнозирование оттока клиентов (Churn Prediction): Выявление клиентов, которые вероятно прекратят пользоваться услугами, и разработка проактивных стратегий их удержания.

- Анализ тональности (Sentiment Analysis): Автоматическое определение отношения клиентов к бренду, продуктам или услугам на основе анализа отзывов, комментариев в соцсетях, обзоров. Позволяет быстро реагировать на проблемы и улучшать репутацию.

- Оптимизация маркетинговых кампаний: Измерение эффективности различных каналов и сообщений, A/B тестирование, распределение маркетингового бюджета для максимальной отдачи (ROI).

Оптимизация Операционной Деятельности и Цепочек Поставок

Big Data помогает сделать внутренние процессы компании более эффективными и прозрачными:

- Управление цепочками поставок (Supply Chain Management): Прогнозирование спроса на основе исторических данных, данных о погоде, социальных трендов; оптимизация уровня запасов на складах во избежание дефицита или излишков; отслеживание грузов в реальном времени с помощью GPS и RFID; оптимизация маршрутов доставки с учетом трафика и других факторов.

- Производство: Анализ данных с IoT-сенсоров на производственном оборудовании для мониторинга его состояния и прогнозирования возможных поломок (предиктивное обслуживание), что позволяет избежать дорогостоящих простоев; контроль качества продукции в режиме реального времени; оптимизация производственных параметров для повышения эффективности и снижения брака.

- Управление рисками: В финансовом секторе – анализ транзакций для выявления мошенничества в реальном времени; оценка кредитоспособности заемщиков на основе более широкого набора данных; моделирование рыночных рисков. В страховании – более точная оценка рисков и расчет страховых премий.

- Динамическое ценообразование: Установление цен на товары и услуги в зависимости от спроса, предложения, цен конкурентов, времени суток, погоды и других факторов. Активно используется авиакомпаниями, отелями, сервисами такси, интернет-магазинами.

- HR-аналитика (People Analytics): Анализ данных о сотрудниках для улучшения процессов найма (выявление характеристик успешных кандидатов), оценки эффективности работы, выявления факторов, влияющих на вовлеченность и текучесть кадров, планирования потребности в персонале и обучения.

Разработка Новых Продуктов и Услуг

Анализ больших данных может выявить неудовлетворенные потребности клиентов или новые рыночные возможности, что стимулирует инновации и разработку новых продуктов, услуг или даже бизнес-моделей. Например, анализ данных об использовании продукта может подсказать, какие функции наиболее востребованы, а какие требуют доработки.

Примеры Использования Big Data по Отраслям

| Отрасль | Ключевые Применения Big Data |

|---|---|

| Розничная торговля и E-commerce | Рекомендательные системы, персонализированный маркетинг, анализ покупательских корзин (market basket analysis), оптимизация запасов и логистики, динамическое ценообразование, анализ отзывов клиентов. |

| Финансы и Банковское дело | Выявление и предотвращение мошенничества (fraud detection), алгоритмическая торговля (алготрейдинг), оценка кредитных рисков (скоринг), управление активами и портфелем, персонализированные финансовые продукты и советы, анализ клиентского поведения. |

| Здравоохранение (Healthcare) | Анализ электронных медицинских карт для поддержки принятия клинических решений, прогнозирование вспышек заболеваний и эпидемий, персонализированная медицина (подбор лечения на основе геномных данных), анализ медицинских изображений, оптимизация работы больниц, ускорение разработки лекарств. |

| Телекоммуникации | Оптимизация покрытия и пропускной способности сети, анализ и прогнозирование оттока клиентов (churn), сегментация клиентов для маркетинга, разработка новых тарифных планов и услуг, выявление мошенничества. |

| Транспорт и Логистика | Оптимизация маршрутов (учет трафика, погоды), предиктивное обслуживание транспортных средств (самолеты, грузовики), управление транспортными потоками (умные города), отслеживание грузов в реальном времени, оптимизация работы складов. |

| Энергетика | Прогнозирование спроса на электроэнергию, оптимизация генерации (особенно из возобновляемых источников), мониторинг состояния сетей («умные» сети — smart grids), выявление потерь и краж энергии, предиктивное обслуживание оборудования электростанций. |

| Медиа и Развлечения | Рекомендации контента (фильмы, музыка, новости), анализ аудитории и ее предпочтений, таргетированная реклама, измерение вовлеченности пользователей. |

| Государственное управление | Улучшение предоставления государственных услуг, анализ социальных и экономических тенденций, управление городской инфраструктурой («умные города»), борьба с преступностью, реагирование на чрезвычайные ситуации. |

Big Data в Науке: Революция в Исследованиях

Наука всегда была сферой, где данные играли ключевую роль. Однако появление технологий Big Data кардинально меняет подходы к исследованиям, позволяя обрабатывать и анализировать беспрецедентные объемы информации, генерируемой современными инструментами и экспериментами. Это приводит к ускорению открытий и появлению новых направлений исследований – так называемой «науки, управляемой данными» (data-driven science).

- Геномика и Биоинформатика: Секвенирование (расшифровка) геномов генерирует огромные объемы данных (терабайты на один геном). Анализ этих данных позволяет ученым находить гены, связанные с наследственными заболеваниями, понимать механизмы их развития, изучать эволюцию видов, разрабатывать методы персонализированной медицины, где лечение подбирается индивидуально на основе генетических особенностей пациента. Проекты типа «Геном Человека» или UK Biobank являются яркими примерами использования Big Data.

- Астрономия и Физика: Современные телескопы (наземные и космические, как Hubble или James Webb Space Telescope) и радиоинтерферометры (например, будущий Square Kilometre Array — SKA) собирают петабайты изображений и данных о космических объектах. Физические эксперименты, особенно на ускорителях частиц, таких как Большой адронный коллайдер (LHC) в CERN, генерируют колоссальные потоки данных (десятки петабайт в год). Анализ этих данных помогает искать новые галактики, планеты, черные дыры, изучать темную материю и темную энергию, проверять фундаментальные теории строения Вселенной и элементарных частиц.

- Климатология и Науки о Земле: Климатические модели, используемые для прогнозирования изменений климата, работают с огромными наборами данных (температура, осадки, уровень океана, концентрация газов) за длительные периоды. Спутники дистанционного зондирования Земли генерируют терабайты данных о состоянии атмосферы, океанов, ледников, растительности. Анализ этих данных помогает понимать процессы глобального потепления, прогнозировать экстремальные погодные явления (ураганы, наводнения, засухи), оценивать влияние человеческой деятельности на окружающую среду.

- Медицинские исследования и Эпидемиология: Анализ больших массивов анонимизированных электронных медицинских карт, результатов клинических испытаний, данных медицинских изображений (МРТ, КТ), данных с носимых устройств пациентов позволяет выявлять факторы риска развития заболеваний, оценивать эффективность различных методов лечения, прогнозировать распространение инфекционных заболеваний и эпидемий (как это было во время пандемии COVID-19), ускорять процесс разработки и тестирования новых лекарств.

- Социальные и Гуманитарные науки: Анализ больших объемов данных из социальных сетей, новостных потоков, оцифрованных архивов, результатов массовых опросов позволяет изучать общественные настроения, политические процессы, распространение информации (и дезинформации), миграционные потоки, культурные тенденции, исторические события на новом уровне детализации.

Big Data в науке – это инструмент, позволяющий проверять гипотезы на гораздо больших массивах данных, выявлять сложные, нелинейные взаимосвязи, которые ранее оставались незамеченными, и делать открытия, которые были бы невозможны при традиционных методах исследования.

Основные Вызовы и Риски, Связанные с Big Data

Несмотря на огромный потенциал, внедрение и эффективное использование технологий Big Data связано с рядом серьезных вызовов и потенциальных рисков:

- Стоимость инфраструктуры и хранения: Хранение и обработка петабайтов данных требует значительных инвестиций в аппаратное обеспечение (серверы, системы хранения данных), программное обеспечение и сетевую инфраструктуру. Хотя облачные платформы могут снизить первоначальные затраты, долгосрочные расходы все равно могут быть существенными.

- Безопасность данных и Конфиденциальность: Защита огромных массивов данных от кибератак, утечек и несанкционированного доступа является чрезвычайно сложной задачей. Особенно остро стоит вопрос защиты персональных данных (медицинских, финансовых, поведенческих). Необходимо внедрять надежные механизмы шифрования, контроля доступа и соблюдать требования законодательства о защите данных (например, европейского GDPR).

- Проблема качества и достоверности данных (Veracity): Как уже отмечалось, большие данные часто бывают неполными, неточными, противоречивыми. Процессы очистки, валидации и обогащения данных (data preparation) трудоемки, занимают значительную часть времени (до 80% по некоторым оценкам) и требуют специальных навыков. Ошибки в данных могут привести к ошибочным выводам.

- Дефицит квалифицированных специалистов: Существует острая нехватка специалистов, обладающих необходимыми знаниями и навыками для работы с Big Data: инженеров данных (Data Engineers), аналитиков данных (Data Analysts) и специалистов по данным (Data Scientists). Эти специалисты должны сочетать знания в области статистики, программирования, машинного обучения и конкретной предметной области.

- Сложность технологий и интеграции: Экосистема инструментов Big Data (Hadoop, Spark, NoSQL базы данных и т.д.) достаточно сложна, постоянно развивается и требует высокой технической экспертизы для настройки, управления и интеграции с существующими ИТ-системами компании.

- Этические проблемы и предвзятость (Bias): Алгоритмы машинного обучения, обученные на исторических данных, могут воспроизводить и даже усиливать существующие в обществе предубеждения (например, расовые или гендерные). Это может приводить к дискриминационным решениям в таких сферах, как кредитование, найм на работу, правосудие. Возникают вопросы относительно прозрачности алгоритмов («черный ящик»), ответственности за их решения и потенциального использования данных для манипуляции поведением людей.

- Управление данными (Data Governance): Необходимость внедрения четких политик и процедур относительно того, как данные собираются, хранятся, кто имеет к ним доступ, как обеспечивается их качество и соответствие нормативным требованиям.

Будущее Big Data: Тенденции и Перспективы

Сфера больших данных далека от стабилизации и продолжает активно развиваться. Можно выделить несколько ключевых тенденций, которые будут определять ее будущее:

- Еще более тесная интеграция с Искусственным Интеллектом (AI) и Машинным Обучением (ML): AI/ML становятся де-факто основными инструментами для анализа Big Data. Развитие глубокого обучения (Deep Learning) позволяет анализировать сложные неструктурированные данные (изображения, текст, речь) на новом уровне. В будущем ожидается еще большая автоматизация аналитических процессов с помощью AI.

- Рост роли аналитики в реальном времени (Real-time Analytics): Потребность получать инсайты и принимать решения мгновенно, на основе потоковых данных, будет расти во многих отраслях (финансы, логистика, производство, кибербезопасность, персонализированный маркетинг).

- Доминирование облачных платформ: Большинство компаний будут использовать облачные сервисы (AWS, Google Cloud, Microsoft Azure и др.) для хранения, обработки и анализа Big Data из-за их масштабируемости, гибкости и доступа к передовым инструментам аналитики и AI/ML «как услуги».

- Периферийные (граничные) вычисления (Edge Computing): В связи со взрывным ростом IoT, все больше данных будет обрабатываться не в централизованных дата-центрах, а непосредственно на «периферии» – на самих устройствах или рядом с ними. Это уменьшает задержки, экономит пропускную способность сети и повышает конфиденциальность.

- Расширенная аналитика (Augmented Analytics): Использование AI/ML для автоматизации многих этапов аналитического процесса, таких как подготовка данных, выявление закономерностей, генерация гипотез и визуализация результатов, делая аналитику доступнее для более широкого круга пользователей (citizen data scientists).

- Повышенное внимание к Этике, Прозрачности и Управлению данными (Data Governance): В ответ на обеспокоенность по поводу конфиденциальности, предвзятости и безопасности, будет расти важность разработки этических принципов использования данных, обеспечения прозрачности алгоритмов (Explainable AI — XAI) и внедрения надежных систем управления данными.

- Графовые базы данных и аналитика: С ростом важности анализа связей (в социальных сетях, цепочках поставок, выявлении мошенничества) будет расти популярность графовых технологий.

Вывод: Данные — Новая Нефть Цифровой Экономики

Big Data – это не просто технологический термин или временный тренд, это фундаментальный сдвиг в способе функционирования современного мира, где данные стали одним из самых ценных активов. Огромные, разнообразные и быстрорастущие потоки информации, генерируемые ежесекундно, содержат в себе невероятный потенциал для трансформации практически всех сфер человеческой деятельности – от бизнеса и науки до государственного управления и повседневной жизни.

Для бизнеса эффективный анализ больших данных становится ключевым фактором конкурентоспособности. Он позволяет глубже понимать клиентов и персонализировать взаимодействие с ними, оптимизировать операционные процессы и цепочки поставок, эффективнее управлять рисками, стимулировать инновации и создавать новые бизнес-модели. Компании, игнорирующие возможности Big Data, рискуют остаться позади.

Для науки Big Data открывает беспрецедентные возможности для исследований и открытий. Анализ огромных массивов данных позволяет решать сложные проблемы в геномике, астрономии, климатологии, медицине, социальных науках, выявлять неочевидные закономерности и значительно ускорять научный прогресс, переходя к парадигме исследований, управляемых данными.

Конечно, путь к полноценному использованию потенциала Big Data не лишен вызовов, таких как обеспечение безопасности и конфиденциальности, преодоление проблем с качеством данных, подготовка квалифицированных кадров и решение этических дилемм. Однако технологии продолжают стремительно развиваться, делая анализ данных все более мощным, доступным и автоматизированным.

Умение эффективно работать с большими данными – собирать, обрабатывать, анализировать и, главное, извлекать из них ценность – становится критически важным навыком для организаций и специалистов в XXI веке. Будущее, несомненно, принадлежит тем, кто сможет превратить информационный потоп в океан возможностей.