У сучасному цифровому світі щомиті генеруються величезні обсяги інформації. Від наших дописів у соціальних мережах та онлайн-покупок до даних з наукових експериментів та датчиків Інтернету речей – ми живемо в епоху великих даних, або Big Data. Але що саме означає цей термін і чому він став таким важливим? Значення великих даних важко переоцінити, адже вони відкривають нові горизонти як для комерційних компаній, так і для наукових установ; про це та багато іншого поговоримо далі на imariupolchanyn.com/uk.

Big Data – це не просто “багато даних”. Це термін, що описує набори даних, які є настільки великими за обсягом, різноманітними за форматом та швидкими за надходженням, що їх неможливо ефективно збирати, зберігати, обробляти та аналізувати за допомогою традиційних інструментів управління даними та реляційних баз даних. Ключова ідея полягає не лише в масштабі, але й у потенціалі цих даних: їх глибокий аналіз дозволяє виявляти приховані закономірності, неочевидні кореляції, ринкові тенденції, уподобання клієнтів та іншу корисну інформацію. Саме ця здатність перетворювати сирі дані на цінні знання (інсайти) робить Big Data потужним інструментом для прийняття обґрунтованих бізнес-рішень, прискорення наукових відкриттів, покращення державних послуг та вирішення глобальних проблем. У цій статті ми детально розберемося в концепції великих даних, її фундаментальних характеристиках, технологіях обробки та, найголовніше, розглянемо конкретні приклади того, як аналіз Big Data трансформує сучасний бізнес та науку.

Ключові характеристики Big Data: Класична Модель “3V” та її розширення до “5V” (або більше)

Щоб краще зрозуміти феномен великих даних, експерти спочатку визначили три основні характеристики, відомі як модель “3V”: Обсяг (Volume), Швидкість (Velocity) та Різноманітність (Variety). З часом, у міру розвитку технологій та глибшого розуміння проблеми, цю модель розширили, додавши ще щонайменше дві важливі характеристики: Достовірність (Veracity) та Цінність (Value). Розглянемо кожну з них детальніше.

1. Обсяг (Volume)

Це найбільш інтуїтивно зрозуміла характеристика. Big Data означає надзвичайно великі обсяги даних. Мова йде не про гігабайти, а про терабайти (ТБ), петабайти (ПБ), екзабайти (ЕБ) і навіть зеттабайти (ЗБ) інформації. Для порівняння, один петабайт – це приблизно 20 мільйонів чотирьохдверних шаф, заповнених текстом, або відео високої чіткості тривалістю 13.3 роки. Джерела цих даних колосальні: соціальні мережі (лише Facebook генерує петабайти даних щодня у вигляді постів, фото, відео, лайків), транзакції електронної комерції, дані з мільярдів пристроїв Інтернету речей (IoT), потокове відео та аудіо, супутникові знімки, логи веб-серверів, дані наукових симуляцій та експериментів (наприклад, Великий адронний колайдер). Традиційні системи зберігання та обробки даних просто фізично не спроможні впоратися з такими масштабами.

2. Швидкість (Velocity)

Ця характеристика описує високу швидкість генерації та надходження даних, а також потребу в їх швидкій обробці, часто в режимі реального часу або близькому до нього. Дані не просто накопичуються; вони ллються безперервним потоком. Приклади включають біржові котирування, що оновлюються мілісекунди, постійні потоки даних із соціальних мереж, безперервні показники з промислових датчиків чи медичних моніторів, дані геолокації з мобільних пристроїв. Необхідність аналізувати ці дані “на льоту” (stream processing) є ключовою для багатьох застосувань, таких як виявлення шахрайських транзакцій у момент їх здійснення, моніторинг стану пацієнтів, керування дорожнім рухом чи швидке реагування на зміни ринкових умов. Повільна обробка може зробити отриману інформацію застарілою та марною.

3. Різноманітність (Variety)

Великі дані надходять у надзвичайно різноманітних форматах, що значно ускладнює їх зберігання та аналіз у традиційних структурованих базах даних. Виділяють три основні типи:

- Структуровані дані: Це дані, що мають чітко визначену модель та формат, легко організовуються в таблиці з рядками та стовпцями. Приклади: дані в реляційних базах даних (SQL), таблиці Excel, записи про клієнтів у CRM-системах, фінансові транзакції. Це найбільш звичний тип даних, але він становить лише невелику частку Big Data (близько 20%).

- Напівструктуровані дані: Ці дані не відповідають жорсткій структурі реляційних баз даних, але містять певні теги, маркери або інші організаційні елементи, що полегшують їх аналіз. Приклади: файли XML, JSON, дані веб-сторінок (HTML), електронні листи, дані з деяких NoSQL баз даних.

- Неструктуровані дані: Це дані, що не мають заздалегідь визначеної структури чи моделі. Вони становлять переважну більшість (близько 80%) усіх даних, що генеруються сьогодні. Приклади: текстові документи, повідомлення в месенджерах та соціальних мережах, електронні листи, зображення, аудіофайли, відеозаписи, дані з сенсорів, презентації PowerPoint. Аналіз таких даних потребує складних методів, включаючи обробку природної мови (NLP), комп’ютерний зір та розпізнавання мови.

Ефективна робота з Big Data вимагає здатності інтегрувати та аналізувати дані всіх трьох типів.

4. Достовірність (Veracity)

Ця характеристика стосується ступеня довіри до даних, їх точності, якості та надійності. Великі дані, зібрані з безлічі джерел, часто бувають “брудними” – неповними, суперечливими, неточними, містити помилки введення, дублікати, шуми (наприклад, від сенсорів) або бути упередженими (biased). Дані з соціальних мереж можуть бути суб’єктивними, емоційно забарвленими або навіть цілеспрямовано неправдивими (фейки, дезінформація). Невизначеність та недостовірність даних можуть суттєво вплинути на результати аналізу та призвести до прийняття хибних рішень. Тому забезпечення достовірності даних через процеси очищення (data cleaning), валідації, усунення суперечностей та оцінки надійності джерел є критично важливим і часто дуже трудомістким етапом роботи з Big Data.

5. Цінність (Value)

Мабуть, найважливіша характеристика, яка є кінцевою метою всієї роботи з великими даними. Самі по собі терабайти інформації не мають жодної цінності, якщо їх неможливо перетворити на корисні знання, інсайти та конкретні дії, що приносять користь. Цінність може вимірюватися по-різному: збільшенням прибутку, зниженням витрат, покращенням клієнтського сервісу, оптимізацією процесів, створенням нових продуктів, підвищенням ефективності наукових досліджень, покращенням громадського здоров’я тощо. Визначення потенційної цінності даних та розробка стратегії її вилучення та використання є ключовим завданням для будь-якої організації, що інвестує в технології Big Data. Без чіткого розуміння того, яку цінність потрібно отримати, аналіз великих даних ризикує перетворитися на дорогий процес заради процесу.

Іноді до цих п’яти “V” додають й інші, такі як Варіативність (Variability) – мінливість потоків даних, та Візуалізація (Visualization) – необхідність представляти результати у зрозумілому вигляді.

Основні Джерела Big Data

Розуміння джерел великих даних допомагає усвідомити їх всюдисущість та потенціал. Основними “генераторами” Big Data є:

- Інтернет та Соціальні мережі: Це одне з найбагатших джерел. Сюди входять дані з веб-сайтів (логи відвідувань, кліки, шляхи навігації), пошукових систем (запити користувачів), блоги, форуми, огляди товарів, та, звичайно, соціальні платформи (Facebook, Instagram, Twitter, LinkedIn, TikTok та ін.). Генеруються величезні обсяги текстових даних, зображень, відео, лайків, репостів, коментарів, даних про зв’язки між користувачами та їхні інтереси.

- Машинні дані (Machine-Generated Data) / Інтернет речей (IoT): Мільярди пристроїв, підключених до мережі, безперервно генерують дані. Це можуть бути промислові датчики (температура, тиск, вібрація на обладнанні), сенсори на транспорті (GPS, швидкість, витрата палива), лічильники комунальних послуг (“розумні” лічильники електроенергії, води, газу), носимі пристрої (фітнес-трекери, смарт-годинники, медичні монітори), камери відеоспостереження, “розумні” домашні пристрої (термостати, освітлення) та багато іншого. Ці дані часто надходять у реальному часі.

- Транзакційні дані: Дані, що генеруються в результаті операційної діяльності компаній. Сюди відносяться записи про продажі, покупки, банківські транзакції, дані з платіжних систем, записи про доставку товарів, дані з систем управління взаємовідносинами з клієнтами (CRM), систем планування ресурсів підприємства (ERP), дані кол-центрів (записи дзвінків, логи чатів).

- Мультимедійні дані: Величезні обсяги неструктурованих даних у вигляді фотографій (Flickr, Instagram), відео (YouTube, Netflix, TikTok, камери спостереження), аудіозаписів (подкасти, музичні стрімінгові сервіси, записи розмов). Їх аналіз (наприклад, розпізнавання образів чи мови) становить окремий виклик.

- Наукові дані: Результати експериментів, спостережень та симуляцій у різних галузях науки. Наприклад, дані секвенування геному, астрономічні спостереження (знімки неба, дані радіотелескопів), результати кліматичного моделювання, дані фізичних експериментів (як на LHC), медичні дослідження (клінічні випробування, дані електронних медичних карток).

- Публічні (відкриті) дані: Дані, що надаються урядовими установами, міжнародними організаціями та некомерційними структурами. Це можуть бути демографічні дані (перепис населення), економічна статистика, метеорологічні дані, дані про транспортну інфраструктуру, екологічний моніторинг, державні реєстри тощо.

- Біометричні дані: Дані, пов’язані з унікальними фізичними характеристиками людини, такі як відбитки пальців, сканування сітківки ока, розпізнавання обличчя, аналіз голосу. Використовуються для ідентифікації та безпеки.

Технологічний Стеk та Етапи Аналізу Big Data

Аналіз великих даних – це багатоетапний процес, що вимагає використання спеціалізованих технологій та інструментів, які часто називають “екосистемою Big Data”. Основні етапи та ключові технології:

- 1. Збір даних (Data Acquisition/Ingestion): На цьому етапі відбувається збір сирих даних з різноманітних джерел. Використовуються інструменти для передачі даних, такі як Apache Kafka (для потокової передачі даних у реальному часі), Apache Flume, Sqoop (для передачі даних між Hadoop та реляційними базами даних), а також різні API та ETL-інструменти (Extract, Transform, Load).

- 2. Зберігання даних (Data Storage): Через характеристики Big Data (обсяг, різноманітність), традиційні реляційні бази даних часто не підходять. Використовуються:

- Розподілені файлові системи: Найвідоміша – HDFS (Hadoop Distributed File System), яка дозволяє зберігати величезні файли, розбиваючи їх на блоки та розподіляючи по кластеру звичайних серверів.

- NoSQL бази даних: Не реляційні бази даних, оптимізовані для різних моделей даних та масштабованості. Основні типи:

- Документні (MongoDB, Couchbase): Зберігають дані у вигляді документів (наприклад, JSON).

- Ключ-значення (Redis, Riak): Прості сховища пар ключ-значення.

- Колонкові (Cassandra, HBase): Оптимізовані для запитів по колонках, добре підходять для великих наборів даних з невеликою кількістю колонок.

- Графові (Neo4j, Amazon Neptune): Призначені для зберігання та аналізу даних зі складними зв’язками (наприклад, соціальні мережі, рекомендаційні системи).

- Озера даних (Data Lakes): Сховища, що дозволяють зберігати великі обсяги сирих даних у їхньому нативному форматі без попередньої структуризації. Це забезпечує гнучкість для подальшого аналізу.

- Сховища даних (Data Warehouses): Більш структуровані сховища, що містять очищені та інтегровані дані, оптимізовані для бізнес-аналітики та звітності. Часто використовуються разом з озерами даних.

- 3. Обробка даних (Data Processing): Це етап очищення, трансформації, агрегації та підготовки даних для аналізу. Через великі обсяги використовуються фреймворки для розподілених обчислень:

- Apache Hadoop (з MapReduce): Історично перший популярний фреймворк для пакетної обробки великих даних. MapReduce – це модель програмування для розподілених обчислень.

- Apache Spark: Більш сучасний та швидкий фреймворк, який може виконувати обробку даних в оперативній пам’яті (in-memory processing), що значно прискорює роботу. Підтримує як пакетну обробку, так і обробку потокових даних (Spark Streaming), SQL-запити (Spark SQL) та машинне навчання (MLlib).

- Інші фреймворки: Apache Flink (для потокової обробки), Apache Storm.

- 4. Аналіз даних (Data Analysis): Застосування алгоритмів та методів для виявлення цінних інсайтів. Це може включати:

- Описова аналітика (Descriptive Analytics): Що сталося? (Звіти, дашборди)

- Діагностична аналітика (Diagnostic Analytics): Чому це сталося? (Пошук причин)

- Предиктивна аналітика (Predictive Analytics): Що може статися? (Прогнозування майбутніх подій за допомогою статистичних моделей та машинного навчання)

- Приписова аналітика (Prescriptive Analytics): Що потрібно зробити? (Рекомендації щодо оптимальних дій)

- Статистичний аналіз, Машинне навчання (ML), Глибоке навчання (DL), Обробка природної мови (NLP), Аналіз настроїв (Sentiment Analysis), Аналіз часових рядів, Кластеризація, Класифікація.

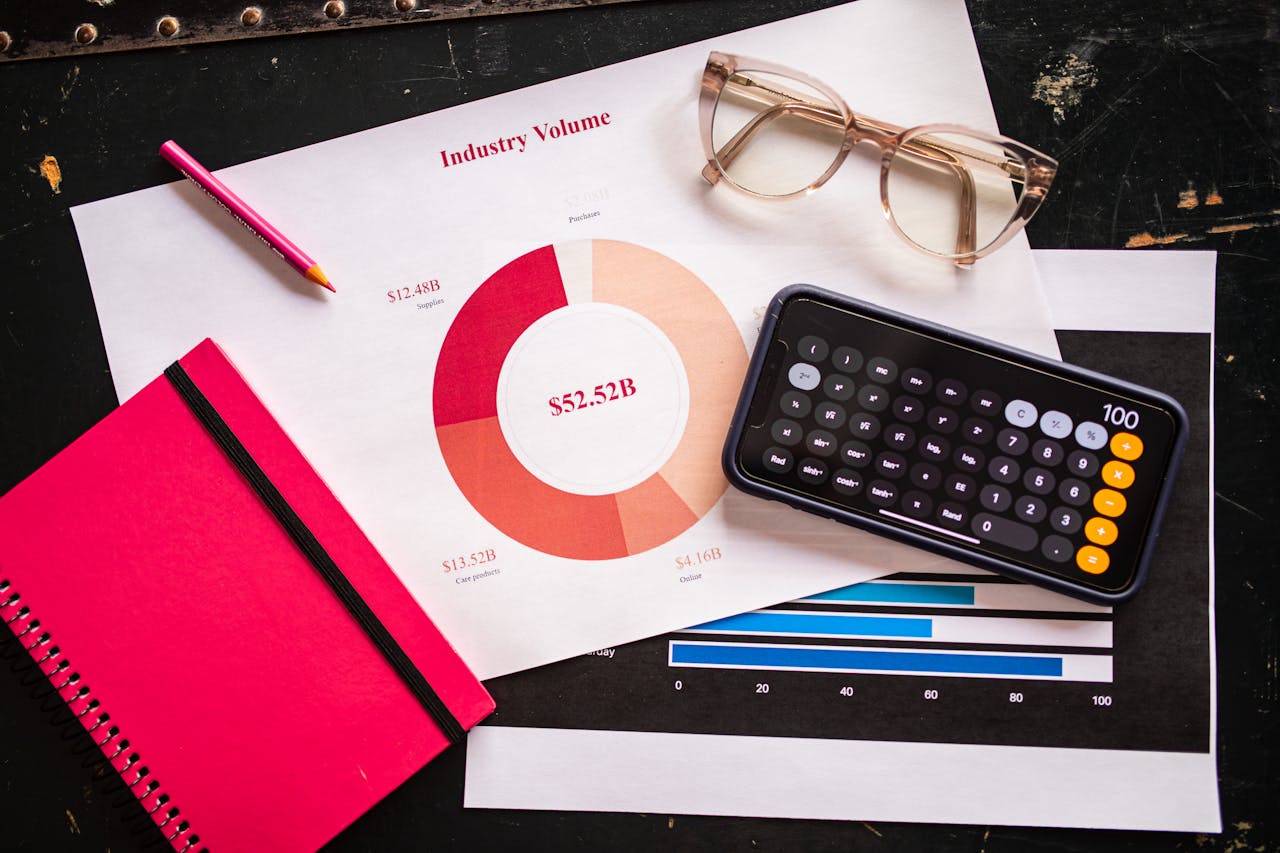

- 5. Візуалізація даних та Інтерпретація (Data Visualization & Interpretation): Представлення результатів аналізу у зрозумілій візуальній формі (графіки, діаграми, карти, інтерактивні дашборди) для полегшення розуміння та прийняття рішень. Популярні інструменти: Tableau, Microsoft Power BI, Qlik Sense, Looker, D3.js. На цьому етапі відбувається інтерпретація результатів та формулювання висновків.

Застосування Big Data в Бізнесі: Від Оптимізації до Інновацій

Для сучасного бізнесу аналіз великих даних перетворився з опції на стратегічну необхідність. Компанії використовують інсайти, отримані з Big Data, для досягнення конкурентних переваг у багатьох напрямках:

Покращення Розуміння Клієнтів та Персоналізація

Мабуть, найпоширеніше застосування. Аналізуючи історію покупок, поведінку на веб-сайті та в мобільних додатках, активність у соціальних мережах, демографічні дані, відгуки та запити до служби підтримки, компанії можуть створити 360-градусний портрет клієнта. Це дозволяє:

- Глибока сегментація аудиторії: Виділення вузьких груп клієнтів зі схожими потребами та поведінкою для більш точного таргетингу.

- Гіперперсоналізація: Надання індивідуальних пропозицій, контенту та досвіду взаємодії в реальному часі. Класичні приклади – системи рекомендацій товарів на Amazon, фільмів на Netflix, музики на Spotify.

- Прогнозування відтоку клієнтів (Churn Prediction): Виявлення клієнтів, які ймовірно припинять користуватися послугами, та розробка проактивних стратегій їх утримання.

- Аналіз настроїв (Sentiment Analysis): Автоматичне визначення ставлення клієнтів до бренду, продуктів чи послуг на основі аналізу відгуків, коментарів у соцмережах, оглядів. Дозволяє швидко реагувати на проблеми та покращувати репутацію.

- Оптимізація маркетингових кампаній: Вимірювання ефективності різних каналів та повідомлень, A/B тестування, розподіл маркетингового бюджету для максимальної віддачі (ROI).

Оптимізація Операційної Діяльності та Ланцюгів Поставок

Big Data допомагає зробити внутрішні процеси компанії більш ефективними та прозорими:

- Управління ланцюгами поставок (Supply Chain Management): Прогнозування попиту на основі історичних даних, даних про погоду, соціальних трендів; оптимізація рівня запасів на складах для уникнення дефіциту або надлишків; відстеження вантажів у реальному часі за допомогою GPS та RFID; оптимізація маршрутів доставки з урахуванням трафіку та інших факторів.

- Виробництво: Аналіз даних з IoT-сенсорів на виробничому обладнанні для моніторингу його стану та прогнозування можливих поломок (предиктивне обслуговування), що дозволяє уникнути дорогих простоїв; контроль якості продукції в режимі реального часу; оптимізація виробничих параметрів для підвищення ефективності та зниження браку.

- Управління ризиками: У фінансовому секторі – аналіз транзакцій для виявлення шахрайства в реальному часі; оцінка кредитоспроможності позичальників на основі ширшого набору даних; моделювання ринкових ризиків. У страхуванні – більш точна оцінка ризиків та розрахунок страхових премій.

- Динамічне ціноутворення: Встановлення цін на товари та послуги залежно від попиту, пропозиції, цін конкурентів, часу доби, погоди та інших факторів. Активно використовується авіакомпаніями, готелями, сервісами таксі, інтернет-магазинами.

- HR-аналітика (People Analytics): Аналіз даних про співробітників для покращення процесів найму (виявлення характеристик успішних кандидатів), оцінки ефективності роботи, виявлення факторів, що впливають на залученість та плинність кадрів, планування потреби в персоналі та навчання.

Розробка Нових Продуктів та Послуг

Аналіз великих даних може виявити незадоволені потреби клієнтів або нові ринкові можливості, що стимулює інновації та розробку нових продуктів, послуг або навіть бізнес-моделей. Наприклад, аналіз даних про використання продукту може підказати, які функції є найбільш затребуваними, а які потребують доопрацювання.

Приклади Використання Big Data по Галузях

| Галузь | Ключові Застосування Big Data |

|---|---|

| Роздрібна торгівля та E-commerce | Рекомендаційні системи, персоналізований маркетинг, аналіз купівельних кошиків (market basket analysis), оптимізація запасів та логістики, динамічне ціноутворення, аналіз відгуків клієнтів. |

| Фінанси та Банківська справа | Виявлення та запобігання шахрайству (fraud detection), алгоритмічна торгівля (алготрейдинг), оцінка кредитних ризиків (скоринг), управління активами та портфелем, персоналізовані фінансові продукти та поради, аналіз клієнтської поведінки. |

| Охорона здоров’я (Healthcare) | Аналіз електронних медичних карток для підтримки прийняття клінічних рішень, прогнозування спалахів захворювань та епідемій, персоналізована медицина (підбір лікування на основі геномних даних), аналіз медичних зображень, оптимізація роботи лікарень, прискорення розробки ліків. |

| Телекомунікації | Оптимізація покриття та пропускної здатності мережі, аналіз та прогнозування відтоку клієнтів (churn), сегментація клієнтів для маркетингу, розробка нових тарифних планів та послуг, виявлення шахрайства. |

| Транспорт та Логістика | Оптимізація маршрутів (врахування трафіку, погоди), предиктивне обслуговування транспортних засобів (літаки, вантажівки), управління транспортними потоками (розумні міста), відстеження вантажів у реальному часі, оптимізація роботи складів. |

| Енергетика | Прогнозування попиту на електроенергію, оптимізація генерації (особливо з відновлюваних джерел), моніторинг стану мереж (“розумні” мережі – smart grids), виявлення втрат та крадіжок енергії, предиктивне обслуговування обладнання електростанцій. |

| Медіа та Розваги | Рекомендації контенту (фільми, музика, новини), аналіз аудиторії та її уподобань, таргетована реклама, вимірювання залученості користувачів. |

| Державне управління | Покращення надання державних послуг, аналіз соціальних та економічних тенденцій, управління міською інфраструктурою (“розумні міста”), боротьба зі злочинністю, реагування на надзвичайні ситуації. |

Big Data в Науці: Революція в Дослідженнях

Наука завжди була сферою, де дані відігравали ключову роль. Однак поява технологій Big Data кардинально змінює підходи до досліджень, дозволяючи обробляти та аналізувати безпрецедентні обсяги інформації, що генерується сучасними інструментами та експериментами. Це призводить до прискорення відкриттів та появи нових напрямків досліджень – так званої “науки, керованої даними” (data-driven science).

- Геноміка та Біоінформатика: Секвенування (розшифровка) геномів генерує величезні обсяги даних (терабайти на один геном). Аналіз цих даних дозволяє вченим знаходити гени, пов’язані зі спадковими захворюваннями, розуміти механізми їх розвитку, вивчати еволюцію видів, розробляти методи персоналізованої медицини, де лікування підбирається індивідуально на основі генетичних особливостей пацієнта. Проекти типу “Геном Людини” або UK Biobank є яскравими прикладами використання Big Data.

- Астрономія та Фізика: Сучасні телескопи (наземні та космічні, як Hubble чи James Webb Space Telescope) та радіоінтерферометри (наприклад, майбутній Square Kilometre Array – SKA) збирають петабайти зображень та даних про космічні об’єкти. Фізичні експерименти, особливо на прискорювачах частинок, таких як Великий адронний колайдер (LHC) в CERN, генерують колосальні потоки даних (десятки петабайт на рік). Аналіз цих даних допомагає шукати нові галактики, планети, чорні діри, вивчати темну матерію та темну енергію, перевіряти фундаментальні теорії будови Всесвіту та елементарних частинок.

- Кліматологія та Науки про Землю: Кліматичні моделі, що використовуються для прогнозування змін клімату, працюють з величезними наборами даних (температура, опади, рівень океану, концентрація газів) за тривалі періоди. Супутники дистанційного зондування Землі генерують терабайти даних про стан атмосфери, океанів, льодовиків, рослинності. Аналіз цих даних допомагає розуміти процеси глобального потепління, прогнозувати екстремальні погодні явища (урагани, повені, посухи), оцінювати вплив людської діяльності на навколишнє середовище.

- Медичні дослідження та Епідеміологія: Аналіз великих масивів анонімізованих електронних медичних карток, результатів клінічних випробувань, даних з медичних зображень (МРТ, КТ), даних з носимих пристроїв пацієнтів дозволяє виявляти фактори ризику розвитку захворювань, оцінювати ефективність різних методів лікування, прогнозувати поширення інфекційних захворювань та епідемій (як це було під час пандемії COVID-19), прискорювати процес розробки та тестування нових ліків.

- Соціальні та Гуманітарні науки: Аналіз великих обсягів даних із соціальних мереж, новинних потоків, оцифрованих архівів, результатів масових опитувань дозволяє вивчати суспільні настрої, політичні процеси, поширення інформації (та дезінформації), міграційні потоки, культурні тенденції, історичні події на новому рівні деталізації.

Big Data в науці – це інструмент, що дозволяє перевіряти гіпотези на набагато більших масивах даних, виявляти складні, нелінійні взаємозв’язки, які раніше залишалися непоміченими, та робити відкриття, які були б неможливі при традиційних методах дослідження.

Основні Виклики та Ризики, Пов’язані з Big Data

Попри величезний потенціал, впровадження та ефективне використання технологій Big Data пов’язане з низкою серйозних викликів та потенційних ризиків:

- Вартість інфраструктури та зберігання: Зберігання та обробка петабайтів даних вимагає значних інвестицій у апаратне забезпечення (сервери, системи зберігання даних), програмне забезпечення та мережеву інфраструктуру. Хоча хмарні платформи можуть знизити початкові витрати, довгострокові витрати все одно можуть бути суттєвими.

- Безпека даних та Конфіденційність: Захист величезних масивів даних від кібератак, витоків та несанкціонованого доступу є надзвичайно складним завданням. Особливо гостро стоїть питання захисту персональних даних (медичних, фінансових, поведінкових). Необхідно впроваджувати надійні механізми шифрування, контролю доступу та дотримуватися вимог законодавства про захист даних (наприклад, європейського GDPR або українського Закону “Про захист персональних даних”).

- Проблема якості та достовірності даних (Veracity): Як вже зазначалося, великі дані часто бувають неповними, неточними, суперечливими. Процеси очищення, валідації та збагачення даних (data preparation) є трудомісткими, займають значну частину часу (до 80% за деякими оцінками) та вимагають спеціальних навичок. Помилки в даних можуть призвести до помилкових висновків.

- Дефіцит кваліфікованих фахівців: Існує гостра нестача фахівців, які володіють необхідними знаннями та навичками для роботи з Big Data: інженерів даних (Data Engineers), аналітиків даних (Data Analysts) та науковців з даних (Data Scientists). Ці фахівці повинні поєднувати знання в галузі статистики, програмування, машинного навчання та конкретної предметної області.

- Складність технологій та інтеграції: Екосистема інструментів Big Data (Hadoop, Spark, NoSQL бази даних тощо) є досить складною, постійно розвивається та вимагає високої технічної експертизи для налаштування, управління та інтеграції з існуючими ІТ-системами компанії.

- Етичні проблеми та упередженість (Bias): Алгоритми машинного навчання, навчені на історичних даних, можуть відтворювати та навіть посилювати існуючі в суспільстві упередження (наприклад, расові чи гендерні). Це може призводити до дискримінаційних рішень у таких сферах, як кредитування, найм на роботу, правосуддя. Виникають питання щодо прозорості алгоритмів (“чорна скринька”), відповідальності за їхні рішення та потенційного використання даних для маніпуляції поведінкою людей.

- Управління даними (Data Governance): Необхідність впровадження чітких політик та процедур щодо того, як дані збираються, зберігаються, хто має до них доступ, як забезпечується їх якість та відповідність нормативним вимогам.

Майбутнє Big Data: Тенденції та Перспективи

Сфера великих даних далека від стабілізації і продовжує активно розвиватися. Можна виділити кілька ключових тенденцій, які визначатимуть її майбутнє:

- Ще тісніша інтеграція зі Штучним Інтелектом (AI) та Машинним Навчанням (ML): AI/ML стають де-факто основними інструментами для аналізу Big Data. Розвиток глибокого навчання (Deep Learning) дозволяє аналізувати складні неструктуровані дані (зображення, текст, мову) на новому рівні. У майбутньому очікується ще більша автоматизація аналітичних процесів за допомогою AI.

- Зростання ролі аналітики в реальному часі (Real-time Analytics): Потреба отримувати інсайти та приймати рішення миттєво, на основі потокових даних, буде зростати в багатьох галузях (фінанси, логістика, виробництво, кібербезпека, персоналізований маркетинг).

- Домінування хмарних платформ: Більшість компаній будуть використовувати хмарні сервіси (AWS, Google Cloud, Microsoft Azure, та ін.) для зберігання, обробки та аналізу Big Data через їхню масштабованість, гнучкість та доступ до передових інструментів аналітики та AI/ML “як послуги”.

- Периферійні обчислення (Edge Computing): У зв’язку з вибуховим зростанням IoT, все більше даних буде оброблятися не в централізованих дата-центрах, а безпосередньо на “периферії” – на самих пристроях або поруч з ними. Це зменшує затримки, економить пропускну здатність мережі та підвищує конфіденційність.

- Розширена аналітика (Augmented Analytics): Використання AI/ML для автоматизації багатьох етапів аналітичного процесу, таких як підготовка даних, виявлення закономірностей, генерація гіпотез та візуалізація результатів, роблячи аналітику доступнішою для ширшого кола користувачів (citizen data scientists).

- Підвищена увага до Етики, Прозорості та Управління даними (Data Governance): У відповідь на занепокоєння щодо конфіденційності, упередженості та безпеки, зростатиме важливість розробки етичних принципів використання даних, забезпечення прозорості алгоритмів (Explainable AI – XAI) та впровадження надійних систем управління даними.

- Графові бази даних та аналітика: Зі зростанням важливості аналізу зв’язків (у соціальних мережах, ланцюгах поставок, виявленні шахрайства) зростатиме популярність графових технологій.

Висновок: Дані як Нова Нафта Цифрової Економіки

Big Data – це не просто технологічний термін чи тимчасовий тренд, це фундаментальний зсув у способі функціонування сучасного світу, де дані стали одним із найцінніших активів. Величезні, різноманітні та швидкозростаючі потоки інформації, що генеруються щосекунди, містять у собі неймовірний потенціал для трансформації практично всіх сфер людської діяльності – від бізнесу та науки до державного управління та повсякденного життя.

Для бізнесу ефективний аналіз великих даних стає ключовим фактором конкурентоспроможності. Він дозволяє глибше розуміти клієнтів та персоналізувати взаємодію з ними, оптимізувати операційні процеси та ланцюги поставок, ефективніше управляти ризиками, стимулювати інновації та створювати нові бізнес-моделі. Компанії, які ігнорують можливості Big Data, ризикують залишитися позаду.

Для науки Big Data відкриває безпрецедентні можливості для досліджень та відкриттів. Аналіз величезних масивів даних дозволяє вирішувати складні проблеми в геноміці, астрономії, кліматології, медицині, соціальних науках, виявляти неочевидні закономірності та значно прискорювати науковий прогрес, переходячи до парадигми досліджень, керованих даними.

Звичайно, шлях до повноцінного використання потенціалу Big Data не позбавлений викликів, таких як забезпечення безпеки та конфіденційності, подолання проблем з якістю даних, підготовка кваліфікованих кадрів та вирішення етичних дилем. Проте технології продовжують стрімко розвиватися, роблячи аналіз даних все більш потужним, доступним та автоматизованим.

Уміння ефективно працювати з великими даними – збирати, обробляти, аналізувати та, головне, витягувати з них цінність – стає критично важливою навичкою для організацій та фахівців у XXI столітті. Майбутнє, безсумнівно, належить тим, хто зможе перетворити інформаційний потоп на океан можливостей.